A B Testing Best Practices: Leitfaden für mehr Conversions

A/B Testing bleibt das beliebteste Werkzeug, wenn es um digitale Optimierung geht. Doch obwohl weltweit über 70% aller großen Unternehmen regelmäßig A/B Tests einsetzen, erzielen die wenigsten daraus wirklich messbare Verbesserungen. Klingt paradox. Die eigentlichen Durchbrüche entstehen nämlich nicht durch das bloße Testen, sondern durch systematische Planung, klare Zielsetzung und kluge Auswertung. Wer diese Unterschiede kennt, schöpft das volle Potenzial aus und übertrifft die Konkurrenz spielend.

Inhaltsverzeichnis

- Was sind die wichtigsten A B Testing Best Practices?

- So planst und strukturierst du erfolgreiche A B Tests

- Ergebnisse richtig auswerten und anwenden im Marketing

- Häufige Fehler beim A B Testing vermeiden

Schnelle Zusammenfassung

| Takeaway | Erklärung |

|---|---|

| Klares Ziel und Hypothese definieren | Formulieren Sie spezifische Ziele und Erwartungen vor dem Test. Eine präzise Hypothese ist entscheidend für den Testablauf. |

| Eine Variable pro Test manipulieren | Testen Sie immer nur eine Variable, um den Einfluss klar zu identifizieren. Mehrere Änderungen verhindern klare Ergebnisse. |

| Statistische Signifikanz berücksichtigen | Lassen Sie A/B Tests mindestens 7-14 Tage laufen für verlässliche Ergebnisse. Eine ausreichend große Stichprobe ist notwendig. |

| Ergebnisse im Kontext interpretieren | Analysieren Sie Testergebnisse nicht isoliert, sondern im Hinblick auf Unternehmensziele und langfristige Auswirkungen. |

| Häufige Fehler vermeiden | Seien Sie vorsichtig mit voreiligen Schlüssen und zu vielen gleichzeitig getesteten Variablen, um wirksame Optimierungen sicherzustellen. |

Was sind die wichtigsten A B Testing Best Practices?

A/B Testing ist eine leistungsstarke Methode zur kontinuierlichen Optimierung digitaler Strategien, aber nur wenn sie methodisch und strategisch durchgeführt wird. Die effektivsten A/B Testing Best Practices erfordern mehr als nur zufällige Experimente - sie benötigen einen strukturierten und präzisen Ansatz.

Klare Ziele und Hypothesen Definieren

Der Kern erfolgreicher A/B Tests liegt in der präzisen Zielsetzung. Forschung von Coursera unterstreicht die Bedeutung, vor Beginn eines Tests ein klares Ziel zu formulieren. Dies bedeutet nicht nur zu wissen, was verbessert werden soll, sondern auch eine fundierte Hypothese zu entwickeln.

Eine starke Hypothese folgt einer klaren Struktur:

- Aktuelle Situation: Beschreiben Sie den aktuellen Zustand

- Erwartete Veränderung: Definieren Sie präzise, welche Änderung Sie erwarten

- Erwarteter Effekt: Konkretisieren Sie den erwünschten Outcome

Beispielhypothese: "Wenn wir die Headline unserer Landingpage von generisch zu spezifisch ändern, wird die Conversion Rate um mindestens 15% steigen."

Eine Variable Pro Test

Die Penn State Extension empfiehlt, pro Test nur eine Variable zu manipulieren. Diese Strategie ermöglicht es, direkte Kausalzusammenhänge zu identifizieren. Wenn Sie mehrere Elemente gleichzeitig ändern, wird es unmöglich, den spezifischen Einfluss jeder Anpassung zu bestimmen.

Typische Testvariablen umfassen:

- Überschriften

- Call-to-Action Buttons

- Farbschemas

- Seitenlayouts

- Bildmaterial

Durch das Isolieren einzelner Variablen erhalten Sie präzise und vertrauenswürdige Erkenntnisse über die Wirksamkeit spezifischer Designelemente oder Texte.

Statistische Signifikanz und Testdauer

Nicht jeder Test liefert sofort aussagekräftige Ergebnisse. Marketing-Experten betonen die Notwendigkeit, Tests ausreichend lange laufen zu lassen, um statistische Signifikanz zu gewährleisten.

Eine zu kurze Testdauer kann zu irreführenden Schlussfolgerungen führen. Wichtige Faktoren für eine korrekte Testdauer sind:

- Verkehrsvolumen auf der Website

- Erwartete Conversion-Rate

- Gewünschte statistische Konfidenz

Generell sollten Tests mindestens 7-14 Tage oder bis zu 1000-2000 Conversions laufen, um verlässliche Daten zu generieren. Mehr Details zur Datenanalyse finden Sie in unserem umfassenden Leitfaden über Testergebnisse.

Durch die Beachtung dieser Best Practices transformieren Sie A/B Testing von einem zufälligen Experiment zu einer präzisen, datengesteuerten Optimierungsstrategie.

So planst und strukturierst du erfolgreiche A B Tests

Erfolgreiche A/B Tests erfordern eine methodische Herangehensweise, die weit über simple Zufallsexperimente hinausgeht. Eine sorgfältige Planung und Strukturierung ist der Schlüssel, um aussagekräftige Erkenntnisse zu generieren und datenbasierte Entscheidungen zu treffen.

Datengesteuerte Hypothesenentwicklung

Forschung von Statsig betont die Bedeutung, Hypothesen auf Basis echter Nutzerdaten zu formulieren. Dies bedeutet, zunächst vorhandene Analysen, Nutzer-Feedback und Performance-Metriken sorgfältig zu untersuchen.

Der Prozess der Hypothesenentwicklung umfasst:

- Identifikation von Problemzonen: Wo brechen Nutzer ab?

- Konkrete Verbesserungsvorschläge: Welche spezifischen Änderungen könnten helfen?

- Messbare Erwartungen: Wie sieht der erwartete Effekt konkret aus?

Eine starke Hypothese verbindet Datenanalyse mit präziser Vorhersage. Beispiel: "Basierend auf unseren Conversion-Raten erwarten wir, dass eine direktere Call-to-Action-Formulierung die Buchungsrate um 20% steigert."

Testkonfiguration und Variablenkontrolle

Die Penn State Extension unterstreicht die Notwendigkeit, pro Test nur eine Variable zu manipulieren. Diese Präzision ermöglicht es, direkte Kausalzusammenhänge zu identifizieren.

Wichtige Aspekte der Testkonfiguration:

- Definieren Sie eine Kontrollgruppe

- Wählen Sie eine einzelne, klar definierte Variable

- Bestimmen Sie repräsentative Testgruppen

- Legen Sie vorab Signifikanzniveau und Erfolgskriterien fest

Weitere Details zur optimalen Teststrukturierung finden Sie in unserem Leitfaden zum Split Testing.

Testdurchführung und Ergebnisvalidierung

Fiveable's Business Storytelling Notizen empfehlen, Tests mit mindestens 95% statistischer Konfidenz durchzuführen. Dies bedeutet, ausreichend lange zu testen, um zufällige Schwankungen auszuschließen.

Empfohlene Testparameter:

- Minimale Testdauer: 7-14 Tage

- Ausreichende Stichprobengröße

- Berücksichtigung von Wochenzyklen

- Vermeidung externer Störfaktoren

Nach Abschluss des Tests analysieren Sie die Ergebnisse kritisch. Ist die Verbesserung statistisch signifikant? Rechtfertigt der Effekt weitere Implementierungen?

Eine systematische Herangehensweise verwandelt A/B Testing von einem zufälligen Experiment in eine präzise Optimierungsmethode. Jeder Test liefert wertvolle Erkenntnisse über Nutzerverhalten und Conversion-Potenziale.

To clarify the step-by-step process of effective A/B test planning and execution described in the article, the following table breaks down each key stage and the recommended actions for achieving successful test results:

| Stage | Key Actions |

|---|---|

| Hypothesis Development | Analyze data, define problem areas, set clear and measurable goals |

| Test Configuration | Select one variable, define control group, set criteria |

| Test Execution | Run test 7-14 days, achieve large enough sample, avoid disruptions |

| Result Validation | Ensure 95% significance, analyze for real business impact |

| Continuous Improvement | Document results, iterate based on findings, share insights |

Ergebnisse richtig auswerten und anwenden im Marketing

Die Auswertung von A/B Test-Ergebnissen ist eine entscheidende Phase im Optimierungsprozess, die mehr erfordert als nur das Ablesen von Zahlen. Eine strategische und tiefgehende Analyse ermöglicht es Marketingteams, wertvolle Erkenntnisse in konkrete Verbesserungsmaßnahmen zu transformieren.

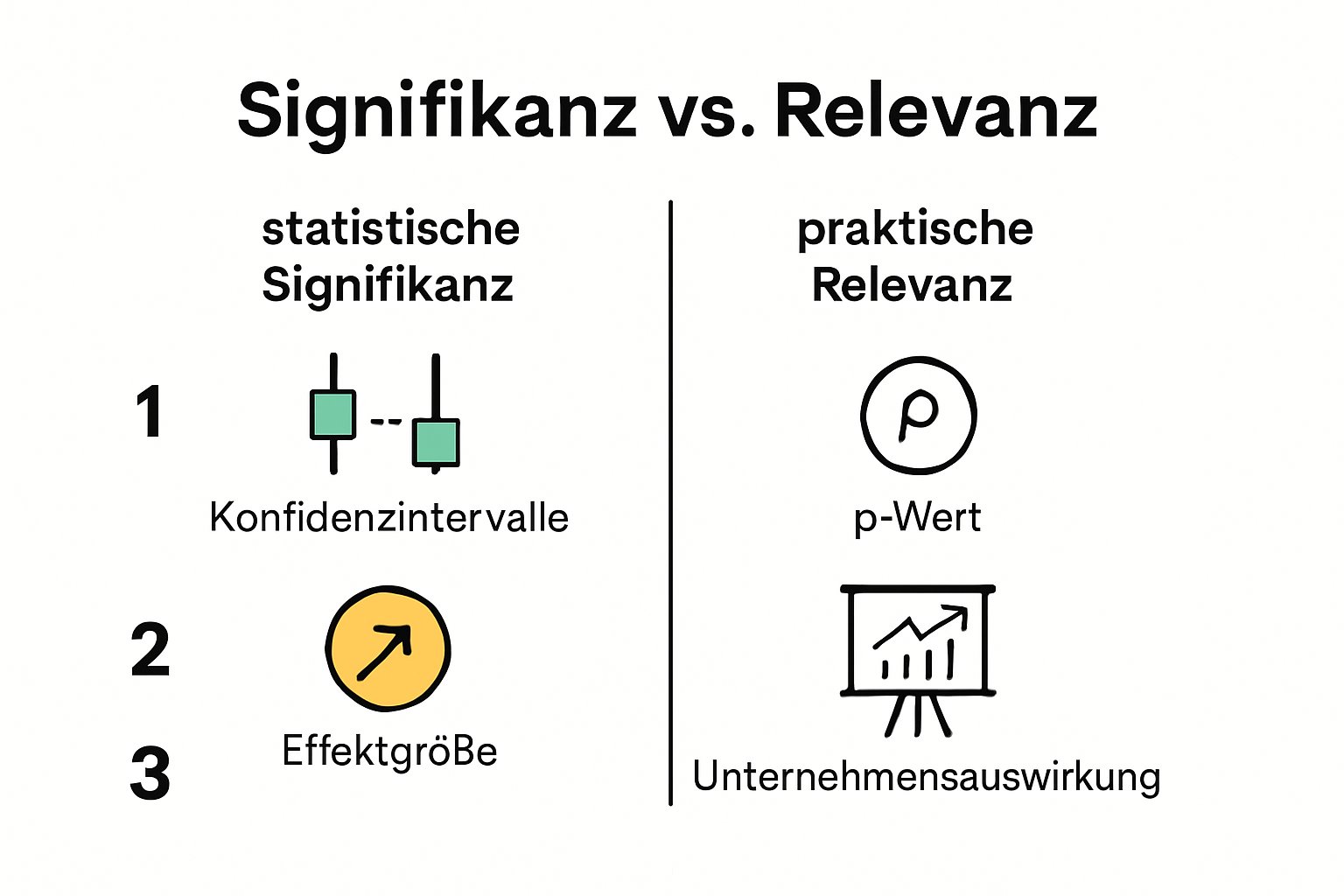

Statistische Signifikanz und Interpretation

Experten von Optimizely betonen, dass die korrekte Interpretation von Testergebnissen mehr ist als ein einfacher Vergleich der Prozentzahlen. Statistische Signifikanz bedeutet, dass die beobachteten Unterschiede nicht auf Zufall beruhen, sondern tatsächlich auf die getestete Variation zurückzuführen sind.

Schlüsselelemente der Ergebnisinterpretation:

- Konfidenzintervall: Bestimmt die Zuverlässigkeit der Ergebnisse

- P-Wert: Misst die Wahrscheinlichkeit zufälliger Ergebnisse

- Effektgröße: Bewertet die praktische Bedeutung der Veränderung

Eine Verbesserung von 2% kann statistisch signifikant sein, aber nicht wirtschaftlich relevant. Daher ist es wichtig, nicht nur die Zahlen zu betrachten, sondern auch deren praktische Bedeutung zu bewerten.

Datengesteuerte Entscheidungsfindung

Forschung von Google Analytics unterstreicht, wie entscheidend datenbasierte Entscheidungsprozesse für moderne Marketingstrategien sind. Die Ergebnisse eines A/B Tests sollten nie isoliert, sondern im Gesamtkontext der Unternehmensziele betrachtet werden.

Praktische Schritte zur Entscheidungsfindung:

- Vergleichen Sie Ergebnisse mit ursprünglichen Hypothesen

- Bewerten Sie die Auswirkungen auf Gesamtkonversionsraten

- Identifizieren Sie unerwartete Erkenntnisse

- Entwickeln Sie Folgeszenarien und weitere Testideen

Mehr Informationen zur datengetriebenen Strategie finden Sie in unserem Leitfaden.

Kontinuierliche Optimierung und Lernprozess

Nach Erkenntnissen von Harvard Business Review ist A/B Testing kein einmaliger Vorgang, sondern ein fortlaufender Lernprozess. Jeder Test liefert Erkenntnisse, unabhängig davon, ob die Ergebnisse den Erwartungen entsprechen oder nicht.

Strategien für kontinuierliche Optimierung:

- Dokumentieren Sie alle Testergebnisse

- Entwickeln Sie neue Hypothesen basierend auf Erkenntnissen

- Implementieren Sie erfolgreiche Varianten

- Teilen Sie Learnings im gesamten Marketingteam

Der Schlüssel liegt nicht im perfekten Test, sondern in der Fähigkeit, aus jedem Experiment zu lernen und die Erkenntnisse direkt in Marketingstrategien zu übersetzen. A/B Testing ist ein dynamischer Prozess der ständigen Verbesserung und Anpassung.

Häufige Fehler beim A B Testing vermeiden

A/B Testing kann ein kraftvolles Instrument zur Optimierung sein - aber nur, wenn es richtig durchgeführt wird. Viele Marketingteams fallen in Fallstricke, die ihre Testergebnisse und Entscheidungsqualität erheblich beeinträchtigen können.

Zu Viele Variablen Gleichzeitig Testen

Computerworld weist darauf hin, dass das gleichzeitige Testen mehrerer Variablen eine der häufigsten Fehlerquellen im A/B Testing ist. Wenn Sie mehrere Elemente gleichzeitig ändern, wird es unmöglich, den spezifischen Einfluss jeder einzelnen Variation zu identifizieren.

Typische Fehler bei Multivariablen-Tests:

- Änderungen an Design und Copytext gleichzeitig

- Manipulation von Farbschema und Seitenstruktur

- Modifikation von Überschrift und Call-to-Action

Die Lösung liegt in der Isolierung einzelner Variablen. Testen Sie zunächst eine Komponente, analysieren Sie die Ergebnisse und entwickeln Sie dann weitere Hypothesen.

Metriken OhneBusinesskontext Interpretieren

Adobe betont, wie wichtig es ist, Testmetriken im Kontext der Geschäftsziele zu bewerten. Ein höherer Klickwert bedeutet nicht automatisch einen Erfolg, wenn diese Klicks nicht in tatsächliche Conversions oder Umsatz übersetzt werden.

Wichtige Aspekte bei der Metrikenauswahl:

- Primäre Geschäftsziele definieren

- Relevante KPIs identifizieren

- Direkte Verbindung zum Umsatz herstellen

- Langfristige Auswirkungen berücksichtigen

Statistische Signifikanz und Voreiligkeit

Ein weitverbreiteter Fehler ist das vorzeitige Abbrechen von Tests oder das Ziehen vorschneller Schlüsse. Statistische Signifikanz erfordert Zeit und eine ausreichend große Stichprobe. Zu frühe Entscheidungen können zu falschen Rückschlüssen und ineffektiven Optimierungen führen.

Empfehlungen zur Vermeidung voreiliger Schlussfolgerungen:

- Definieren Sie vorab die Mindest-Testdauer

- Beachten Sie Schwankungen in Wochenzyklen

- Sammeln Sie genügend Datenpunkte

- Vermeiden Sie emotionale Entscheidungen

Der Schlüssel zum erfolgreichen A/B Testing liegt in Geduld, Präzision und einem systematischen Ansatz. Vermeiden Sie diese häufigen Fehler, und Ihre Optimierungsstrategie wird deutlich effektiver und zuverlässiger.

The article outlines several common A/B testing mistakes and their solutions. This comparison table makes it easy to identify the pitfalls and corresponding best practices to avoid them:

| Common Mistake | Description | How to Avoid |

|---|---|---|

| Too Many Variables Tested | Changing multiple elements at once | Test one variable per test |

| Interpreting Metrics Without Business Context | Analyzing numbers without linking to business goals | Focus on KPIs tied to business outcomes |

| Rushing Tests (Lack of Significance) | Ending tests too early, acting on insufficient data | Define minimum duration and sample size |

Häufige Fragen

Was sind die besten Praktiken für A/B Testing?

A/B Testing Best Practices beinhalten das Festlegen klarer Ziele und Hypothesen, das Testen von nur einer Variablen pro Test, die Berücksichtigung der statistischen Signifikanz und das richtige Interpretieren der Ergebnisse im Kontext des Unternehmens.

Wie lange sollte ein A/B Test durchgeführt werden?

Ein A/B Test sollte mindestens 7-14 Tage laufen oder bis zu 1000-2000 Conversions erreichen, um verlässliche und aussagekräftige Ergebnisse zu gewährleisten.

Wie entwickelt man eine Hypothese für A/B Testing?

Eine Hypothese für A/B Testing sollte die aktuelle Situation beschreiben, eine erwartete Veränderung definieren und den gewünschten Effekt konkretisieren. Beispiel: "Die Änderung der Headline wird die Conversion Rate um mindestens 15% steigern."

Welche Fehler sollten beim A/B Testing vermieden werden?

Häufige Fehler beim A/B Testing sind das Testen von zu vielen Variablen gleichzeitig, das Interpretieren von Metriken ohne Bezug zum Geschäftszyklus und das vorschnelle Abbrechen von Tests, bevor statistische Signifikanz erreicht ist.

Verabschieden Sie sich von A/B Testing Frust – Boost für Ihre Conversions

Viele Marketer kämpfen mit aufwendigen Setups, technischen Hürden und unklaren Ergebnissen. Die im Artikel vorgestellten Best Practices wie klare Hypothesen, einzelne Variablen pro Test und datenbasierte Entscheidungen helfen zwar, doch der Alltag bleibt oft komplex. Gerade kleine Teams verlieren durch komplizierte Tools kostbare Zeit und können das volle Optimierungspotenzial nicht ausschöpfen.

Mit Stellar nehmen Sie die Kontrolle zurück. Erstellen Sie Tests ohne Code. Profitieren Sie vom ultraschnellen 5.4KB Script und übersichtlicher Echtzeit-Analyse. Unsere Plattform bietet alles für herausragende Resultate, ohne Ihre Seite zu verlangsamen. Erleben Sie, wie einfach es sein kann, Hypothesen strukturiert zu testen und echte Conversion-Gewinne zu erzielen.

Testen Sie jetzt die kostenlose Version für Unternehmen mit weniger als 25.000 Nutzern oder entdecken Sie die Vorteile unseres visuellen Editors. Setzen Sie die Tipps aus "A/B Testing Best Practices" sofort um und sichern Sie sich Ihren Wettbewerbsvorteil. Starten Sie noch heute durch – Ihre Conversion-Rate wartet nicht.

Recommended

- Split Testing 2025: Erfolgreiche Optimierung für mehr Conversions

- How to Choose Test Variants: A CRO Marketer’s Guide 2025

- A/B Test Result Reporting: How to Analyze and Present Data (2025)

- Les avantages de l’a/b testing pour booster vos conversions en 2025

- 12 inspirierende A/B-Test-Beispiele für mehr Conversion-Erfolg 2025

Published: 8/10/2025